Logindaten:

HAWKI – https://hawki.hawk.de/

User: KuBi

Passwort: HAWKI

Passkey: 123

RunwayML – https://runwayml.com/

User: post@bundesakademie.de

PW: ba18032025#WF

Udio – https://www.udio.com/create

User: post@bundesakademie.de

Wie verfasse ich einen Prompt?

Ein „Prompt“ ist eine schriftliche Anweisung oder ein Szenario, das dazu dient,

den Schreibprozess oder die Generierung von Inhalten durch eine KI auszulösen. Um aussagekräftige und umfassende Antworten zu erhalten, ist es sinnvoll, die folgenden vier Parameter zu berücksichtigen. Nicht jede Anfrage erfordert jedoch die Einbeziehung aller 4 Parameter.

- Anweisung

Eine bestimmte Aufgabe oder Anweisung, die das Modell

ausführen soll.

- Kontext

Externe Informationen oder zusätzlicher Kontext, der das

Modell zu besseren Antworten lenken kann.

- Input

Die Eingabe oder Frage, auf die wir eine Antwort suchen

- Output

Der Typ oder das Format der Ausgabe. Das können Stile (z.B

wie ein LinkedIn Post), Programmcode (z.B. Python; Html)

oder Tabellen oder Listen sein (z.B. CSV; Checkliste).

Fasse mir den folgenden Text in einfachen Worten zusammen.

Ich bin Lehrer an einer Grundschule und möchte den Kindern das Thema Evolution näher

bringen. Verwende in der Zusammenfassung viele Emojis:

Unter Evolution (von lateinisch evolvere „herausrollen“, „auswickeln“, „entwickeln“) versteht man im deutschsprachigen Raum in erster Linie die biologische Evolution. Darunter wird die von Generation zu Generation stattfindende

allmähliche Veränderung der vererbbaren Merkmale einer Population von

Lebewesen und von anderen organischen Strukturen (z. B. Viren) verstanden.

Das Lehr- und Forschungsgebiet der Evolution wird als Evolutionsbiologie

bezeichnet und unterliegt, wie viele andere Wissenschaften, einem kontinuierlichen Erkenntnisfortschritt. Hierzu können insbesondere neue Einsichten

durch die Entdeckung neuer Fossilien oder die Anwendung neuer Forschungsmethoden beitragen. Das Themenfeld der Evolution wurde zuweilen unterteilt

in die Evolutionsgeschichte, in der die Veränderungen der Lebewesen im Laufe der Erdgeschichte beschrieben werden und bei dem es Überlappungen mit

der Paläontologie gibt, sowie in die Evolutionstheorie, die naturwissenschaftliche Erklärungen (Hypothesen und Theorien) für das Gesamtphänomen der

Evolution entwickelt. Die beiden Ansätze sind heutzutage in der Wissenschaft

innig miteinander verwoben und befruchten sich wechselseitig. Wissenschaftler beschäftigen sich ebenfalls im Rahmen der theoretischen Biologie mit der

biologischen Evolution. Die theoretische Biologie als interdisziplinäres Teilgebiet der Biologie entwickelt mathematische Modelle und führt statistische

Hypothesentests und Laborexperimente durch, um den Erkenntnisgewinn zu

fördern.

Gib mir den Text so aus, als stünde er in einem Kinderbuch.

Bilder und Videos generieren

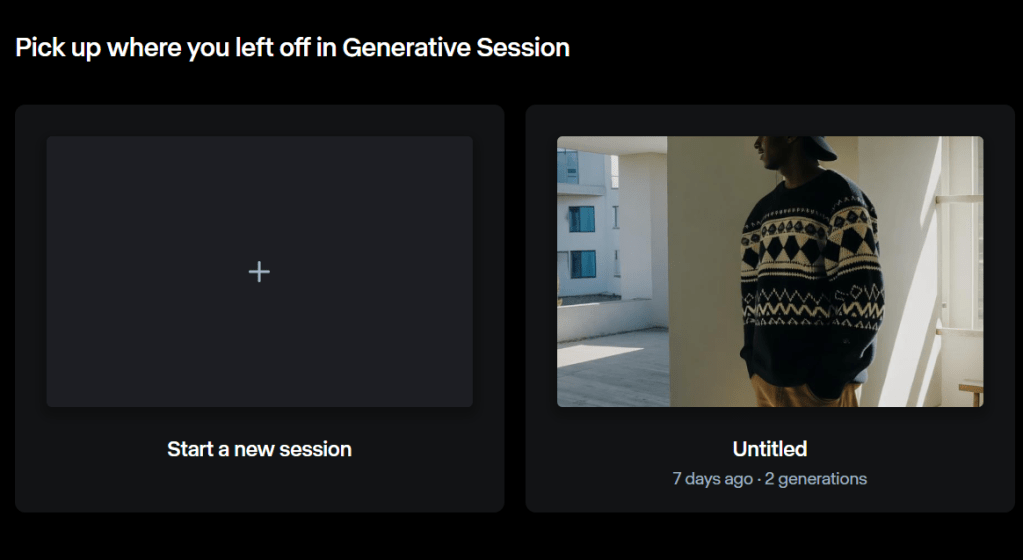

Legt eine neue Session an und gebt ihr einen eindeutigen Namen. Diese Session dient sozusagen als Ordner, in dem ihr später alle generierten Inhalte leicht wiederfindet.

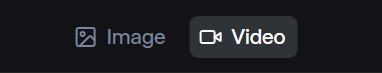

Mit diesem Schalter oben links könnt ihr wählen, ob ihr Videos oder Bilder generieren wollt. Mit Bildern findet ihr zunächst schneller ein passendes Setting und die richtigen Begriffe für den Prompt, auch sind die Wartezeiten nicht so lang wie bei der Videogenerierung.

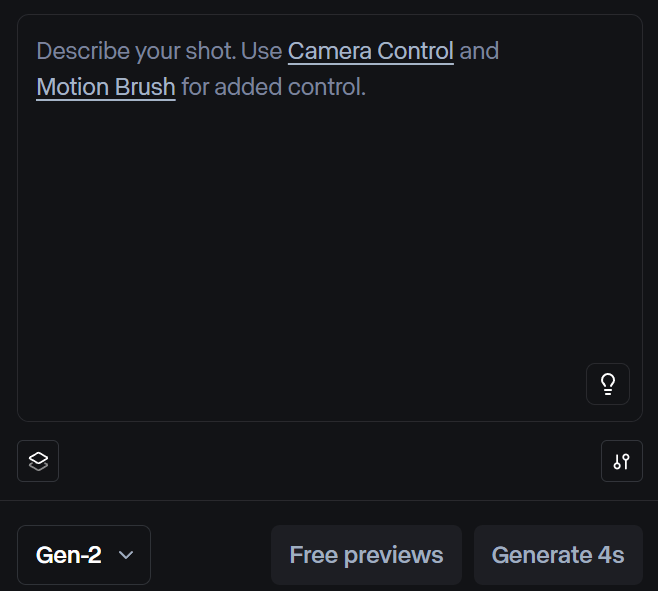

Hier könnt ihr euren Prompt eingeben. Über den Settings-Button unten rechts könnt ihr weitere Detaileinstellungen vornehmen. Das Drop-Down-Menü, in dem momentan „Gen-2“ angezeigt wird, lässt euch verschiedene Modelle auswählen, die unterschiedliche Qualitäten haben und unterschiedlich schnell generieren.

Auf der linken Seite befindet sich die Werkzeugpalette, die sich von Modell zu Modell unterscheidet.

Hier einige spezifische Workflows:

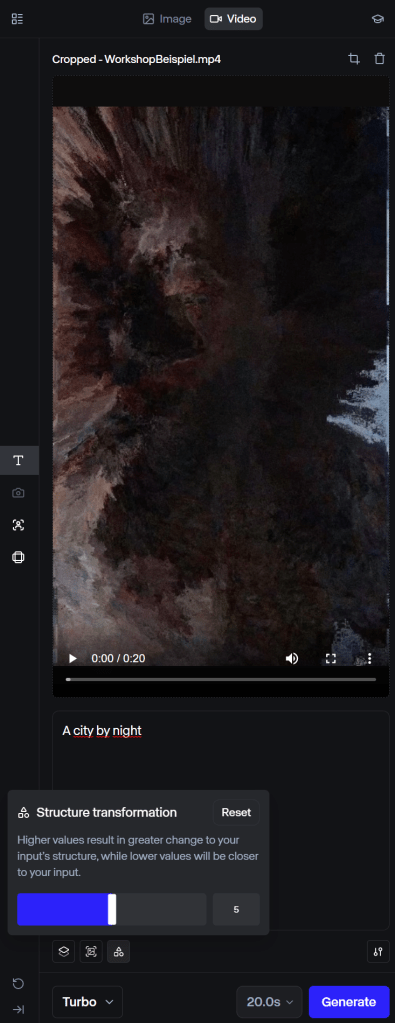

Video zu Video

Um wie in diesem Beispiel die Struktur des Ursprungsvideos zu übernehmen, müssen wir folgende Einstellungen vornehmen.

Je höher der Wert der Strukturtransformation ist, desto mehr Freiheiten nimmt sich das Modell bei der Neuinterpretation des Originalvideos. Wenn die Struktur klar erkennbar sein soll, ist der Wert „3“ eine gute Basis. Aber wie immer gilt: Herumspielen ist ausdrücklich erwünscht! 🙂 Die maximale Länge des Videos darf 20 Sekunden betragen.

Lip-Sync

Act-One nimmt den Ton und die Mimik des Eingangsvideos und überträgt beides auf eine andere Figur. Hier ist eine große Vorauswahl möglich, es können aber auch selbst Bilder z.B. aus dem Internet hochgeladen werden. Wichtig ist nur, dass das Inputvideo gut ausgeleuchtet ist und außer der Mimik wenig Bewegung im Bild ist. Die Kamera sollte also auch ruhig stehen.

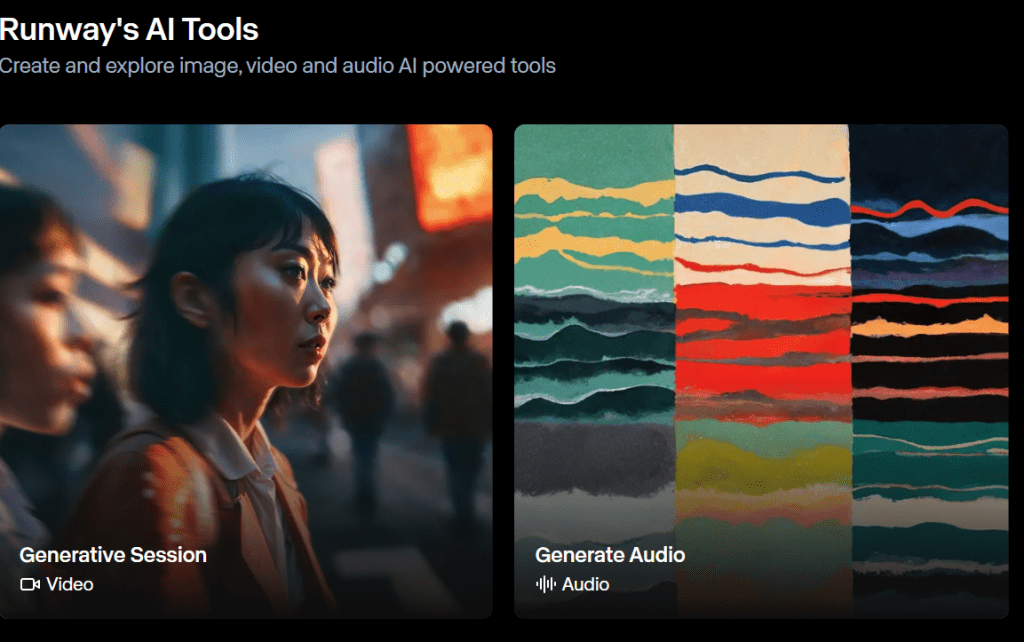

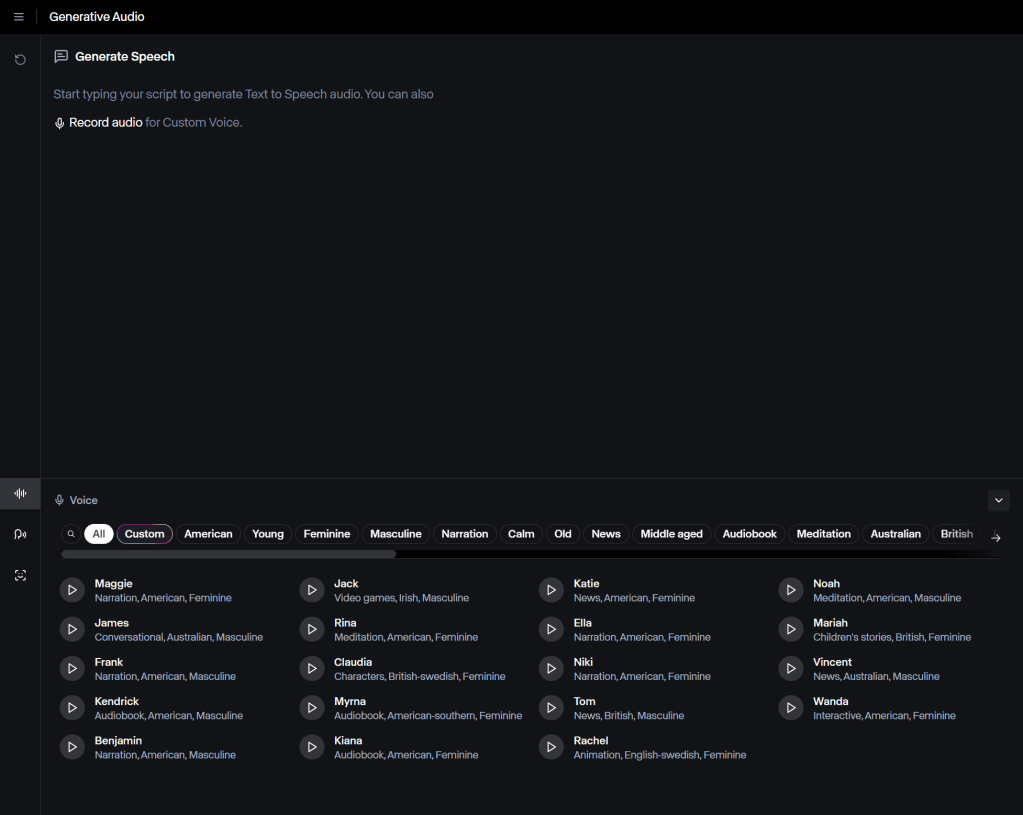

Stimmen generieren

Um Stimmen zu generieren, müssen wir den Arbeitsbereich wechseln. Wir gehen zurück zum Dashboard und finden dort die Auswahl „Generate Audio“.

Hier wird eine große Auswahl an Stimmen angeboten. Wichtig zu wissen ist, dass das KI-Modell die Sprache im Eingabefeld erkennt und dann, obwohl die Beispiele in Englisch sind, auch deutsche Texte problemlos wiedergibt. Es ist auch möglich, die eigene Stimme aufzunehmen, um mehr Kontrolle über die Betonung des Textes zu haben.

Lieder generieren

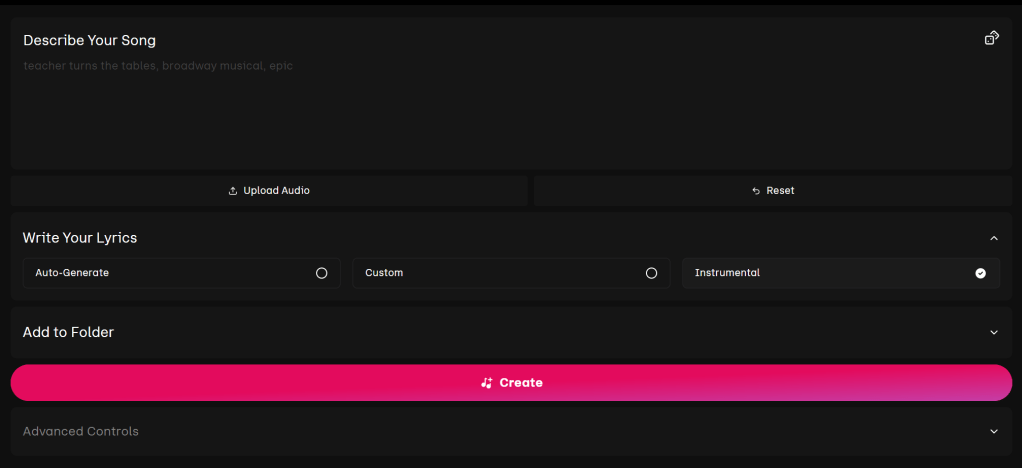

Hier kann im Eingabefeld nicht nur die Musikrichtung beschrieben, sondern auch visuell kommuniziert werden. Wie sieht die Szene aus, die musikalisch untermalt werden soll? Hier kann auch ein Instrumentalstück ausgewählt werden, wenn bereits eine Sprecher*innenstimme im Video vorhanden ist. Wenn du links neben „Instrumental“ „Custom“ auswählst, hast du sogar die Möglichkeit, einen eigene Lyrics anzugeben, die z.B. wiederum mit Hilfe von HAWKI „komponiert“ werden können.

Liste an nützlichen Programmen

Stable Diffusion (Bildgenerierung, Open Source): Ein Open-Source-Bildmodell, das aus Textbeschreibungen erstaunlich realistische oder künstlerische Bilder erzeugt. Stable Diffusion kann lokal auf dem eigenen Rechner oder über Webschnittstellen (z.B. DreamStudio oder verschiedene Community Web Apps) genutzt werden. Es eignet sich, um z.B. im Kunstunterricht Illustrationen zu beliebigen Themen zu erstellen oder Variationen eines Motivs zu generieren. Um diese Bildmodell zu nutzen, kann z.B. die Schnittstelle Automatic1111 heruntergeladen werden. Dort können viele detaillierte Einstellungen vorgenommen, Modelle trainiert und weitere Plugins hinzugefügt werden. Eine weitere Oberfläche ist ComfyUI – diese Oberfläche ist Node-based, das ist eine visuelle Programmierung, bei der man statt Codezeilen zu schreiben, visuelle Knoten verbindet, um Prozesse zu definieren. Weitere Bildmodelle und LoRas findet man auf Civitai.

Midjourney (Bildgenerierung, kommerziell): Wahrscheinlich der beliebteste Bildgenerator, der allerdings auch Geld kostet. Midjourney ist bekannt für seine ästhetisch ansprechenden und qualitativ hochwertigen Fotos und Grafiken, selbst aus kurzen Beschreibungen. Kreative Projekte – vom Design fiktiver Bühnenbilder bis zum Erstellen von Konzeptkunst durch Schüler*innen – profitieren von der großen Stilbandbreite.

ModelScope Text2Video (Video, Open Source): Ein offenes Forschungsmodell, das auf HuggingFace verfügbar ist und aus Textbeschreibungen kurze Videos (wenige Sekunden) generiert. Die Qualität ist noch einfach und erfordert etwas technisches Verständnis, zeigt aber bereits, wohin die Reise geht. Für Fortgeschrittene kann ModelScope spannend sein, um experimentell mit KI-Video zu arbeiten und z.B. KI-generierte Animationen in eigene Projekte zu integrieren.

KlingAI (Videogenerierung, kommerziell): KlingAI ist ein einfach zu bedienendes KI-Tool zur automatischen Erstellung von Videos aus Texten, Bildern oder kurzen Clips. Es eignet sich besonders für Bildungskontexte, da Lehrkräfte und Schüler:innen schnell ansprechende Videoinhalte generieren können, etwa für digitale Storytelling-Projekte, Erklärvideos oder kurze Dokumentationen. Die intuitive Oberfläche ermöglicht es auch Einsteiger:innen, generative KI-Technologien praktisch zu nutzen und kreative Ideen visuell umzusetzen.

Hunyuan3D-2 (3D Modellerstellung, Open Source) Hunyuan ist das neueste 3D-Modellierungstool der asiatischen Firma Tencent (TikTok). 3D-Modelle können einfach durch Eingabe von Text erstellt werden, es ist aber auch möglich, ein Foto hochzuladen und aus dem 2D-Bild ein 3D-Modell zu erstellen.

LumaAI Genie (3D Modellerstellung, kommerziell) Genie macht die Erstellung von 3D-Modellen durch Texteingabe besonders einfach. In wenigen Sekunden erhält man 4 verschiedene 3D-Modelle, die in weiteren Schritten verfeinert werden können.

Weiterbildungsangebote

Download der Handreichung

Welcher KI-Typ bist du?

Lade diese Word-Datei herunter und füge den Inhalt als System-Prompt in HAWKI ein. Du kannst dann einfach mit dem System sprechen, es führt dich durch den Prozess.